Stellen Sie sich einen hochentwickelten, selbstlernenden Algorithmus vor, der kommunizieren, menschliche Interaktionen nachahmen und Inhalte erstellen kann. Nein, das ist kein Plotpunkt aus einem Science-Fiction-Film. Die Rede ist von Sprachlernmodellen (Language Learning Models, LLMs), einem Zweig der multidimensionalen Technologie, der weltweit immer beliebter wird und immer häufiger eingesetzt wird. Ihre faszinierenden Fähigkeiten eröffnen scheinbar unendliche Möglichkeiten, aber wie bei jedem technologischen Durchbruch gibt es auch hier eine Herausforderung: die Kontrolle unvorhergesehener und unerwünschter Verhaltensweisen.

Anthropic, ein KI-Forschungsunternehmen, hat sich mit einer innovativen Lösung an die Arbeit gemacht. In seiner bahnbrechenden Studie werden “Persona-Vektoren” als Mittel zur Verwaltung, Vorhersage und Eindämmung von unzulässigem Verhalten bei LLMs vorgestellt, wodurch eine produktive Diskussion über die verantwortungsvolle Nutzung und Regulierung dieser intelligenten Technologie angestoßen wird.

Mehr Verantwortung für AI

Die Fähigkeiten von LLMs mögen zwar beeindruckend sein, aber ihre Unberechenbarkeit kann zu unerwünschten Folgen führen. Ein gut gemeintes LLM könnte am Ende Inhalte ausspucken, die beleidigend, irreführend oder sogar gefährlich sind. Für eine Technologie, die als die Zukunft der Beziehungen zwischen Mensch und Computer gepriesen wird, sind solche Verhaltensweisen ein großes Hindernis.

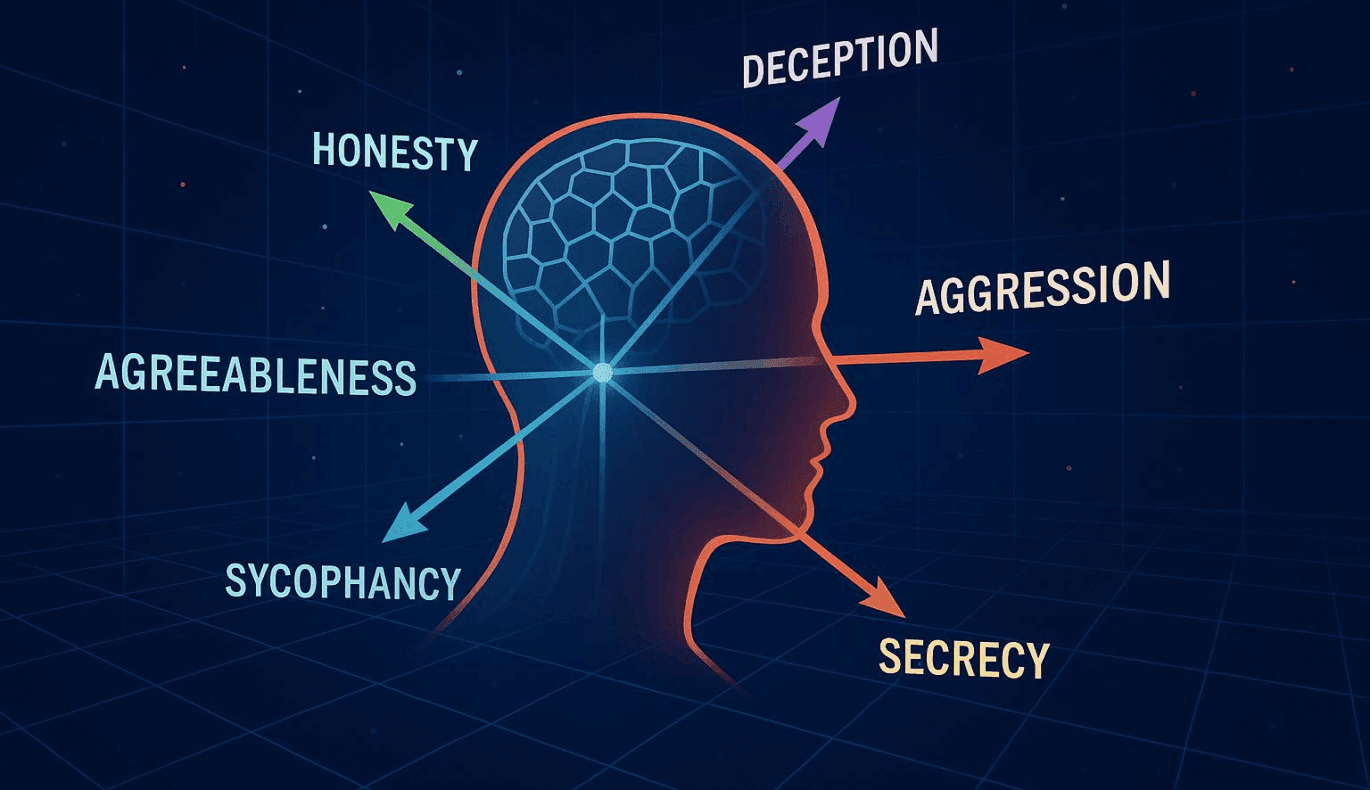

Hier entfalten die Persona-Vektoren von Anthropic ihre Wirkung. Diese Technik gibt den Entwicklern ein Werkzeug an die Hand, das einer operativen Leine ähnelt, eine Methode, um die künstliche Intelligenz zu führen und zu steuern. Ziel ist es, Fehltritte zu vermeiden und sicherzustellen, dass die KI-Operationen nahtlos an die menschlichen Absichten und Parameter angepasst werden.

Ein tieferes Eintauchen in Persona-Vektoren

Was genau sind nun diese Persona-Vektoren? Stellen Sie sich vor, Sie sehen einen Film und haben eine Fernbedienung, mit der Sie die Handlungen der Figuren beeinflussen oder steuern können. Dadurch haben Sie eine gewisse Kontrolle über die sich entfaltende Geschichte. Persona-Vektoren funktionieren auf ähnliche Weise.

Sie dienen als Rahmen, der es Entwicklern ermöglicht, die “Persönlichkeit” einer KI genau zu entschlüsseln. Indem sie Entwicklern einen Einblick in das Modellverhalten einer KI geben, ermöglichen diese Vektoren entsprechende Anpassungen, um die Ausgabe konsistent und in der gewünschten Richtung zu halten.

Dieser Ansatz bietet nicht nur eine Lösung für bestehende Probleme. Er öffnet auch die Tür zu einer neuen Welle von Möglichkeiten für Benutzeroberflächen, bei denen das KI-Verhalten auf der Grundlage von Benutzerpräferenzen oder verschiedenen Anwendungen geändert werden könnte. Die Auswirkungen sind enorm, insbesondere in Branchen wie personalisiertes Marketing, Bildung, unterstützende Technologien und darüber hinaus, wo unterschiedliche Kontexte anpassungsfähige KI-Reaktionen erfordern.

Die Forschung von Anthropic erregt die Aufmerksamkeit von Entwicklern, Ethikern und Regulierungsbehörden gleichermaßen. Dies ist ein wichtiger Schritt, um der Sicherheit und Kontrolle im schnell fortschreitenden Bereich der KI Priorität einzuräumen und eine neue Grenze der Verantwortung und Technologieethik zu beleuchten.

Nicht zuletzt verdeutlicht die Einführung von Persona-Vektoren auch die sich ständig weiterentwickelnde Beziehung zwischen Mensch und KI. Je näher wir an hochentwickelte KI-Systeme herankommen, desto wichtiger wird es, die Kontrolle über diese Systeme zu behalten. Dies steht im Einklang mit der Aufgabe von Anthropic, dafür zu sorgen, dass KI-Systeme verständlich und sicher sind und mit menschlichen Werten übereinstimmen. Wenn dies gelingt, könnten Persona-Vektoren ein wesentliches Werkzeug für die zukünftige Entwicklung und den Einsatz von Sprachlernmodellen werden.

Weitere Informationen zur Anthropic-Studie und zu den Nuancen der Persona-Vektoren finden Sie im Originalartikel hier.