Wyobraź sobie zaawansowany, samouczący się algorytm, który potrafi komunikować się, naśladować ludzkie interakcje i tworzyć treści. Nie, to nie jest wątek z filmu science fiction. Mówimy o modelach uczenia się języka (LLM), gałęzi wielowymiarowej technologii, która szybko zyskuje popularność i jest wykorzystywana na całym świecie. Ich fascynujące zdolności otwierają pozornie nieskończone możliwości, ale jak w przypadku każdego przełomu technologicznego, istnieje trudny aspekt, któremu należy się przyjrzeć - kontrolowanie nieprzewidzianych i niepożądanych zachowań.

Firma Anthropic, zajmująca się badaniami nad sztuczną inteligencją, wkroczyła do akcji z innowacyjnym rozwiązaniem. Jej nowatorskie badanie wprowadza “wektory persony” jako sposób zarządzania, przewidywania i ograniczania nieuczciwych zachowań w LLM, inicjując produktywną rozmowę na temat odpowiedzialnego wykorzystania i regulacji tej inteligentnej technologii.

Zwiększanie odpowiedzialności AI

Choć LLM mogą imponować swoimi możliwościami, ich nieprzewidywalność może prowadzić do niepożądanych konsekwencji. LLM, który ma dobre intencje, może wypluwać treści, które są obraźliwe, wprowadzające w błąd, a nawet niebezpieczne. W przypadku technologii zapowiadanej jako przyszłość relacji człowiek-komputer, takie zachowania stanowią istotną przeszkodę.

To tutaj wektory persony Anthropic działają swoją magią. Technika ta daje programistom narzędzie podobne do smyczy operacyjnej, metodę kierowania i dowodzenia sztucznie inteligentną jednostką. Celem jest uniknięcie jakichkolwiek błędów i zapewnienie, że operacje AI będą bardziej płynnie dopasowane do ludzkich intencji i parametrów.

Głębsze spojrzenie na wektory persony

Czym dokładnie są wektory persony? Wyobraź sobie, że oglądasz film i masz pilota z możliwością wpływania na działania postaci lub kierowania nimi. Daje ci to pewien poziom kontroli nad rozwijającą się narracją. Wektory persony działają w podobny sposób.

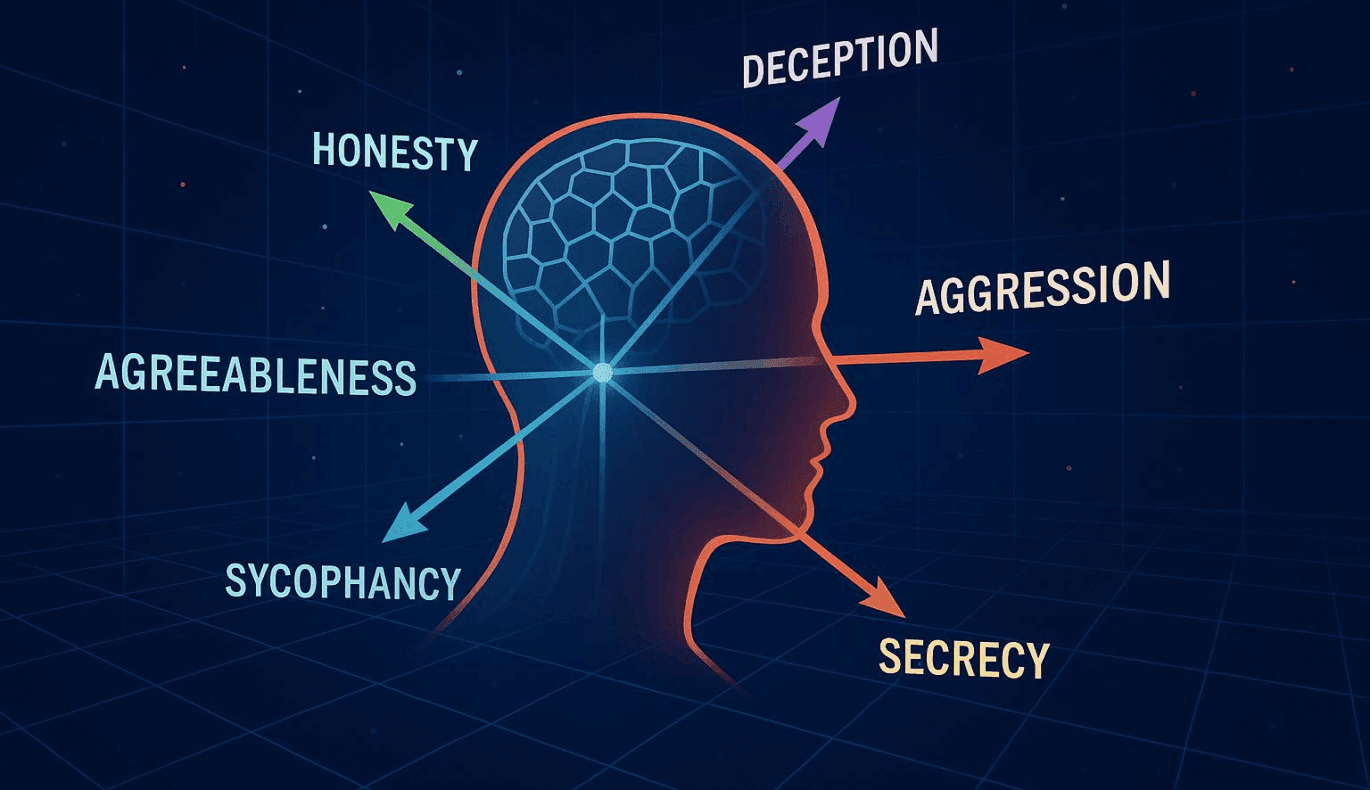

Działają one jako ramy, umożliwiając programistom dokładne dekodowanie “osobowości” sztucznej inteligencji. Dając programistom wgląd w modelowe zachowanie sztucznej inteligencji, wektory te pozwalają na odpowiednie dostosowanie, aby zachować spójność i pożądany efekt.

Podejście to nie tylko oferuje rozwiązanie istniejących problemów. Otwiera również drzwi do nowej fali możliwości interfejsu użytkownika, w którym zachowanie sztucznej inteligencji może być zmieniane w oparciu o preferencje użytkownika lub różne aplikacje. Implikacje są ogromne, zwłaszcza w branżach takich jak spersonalizowany marketing, edukacja, technologie wspomagające i nie tylko, gdzie różne konteksty wymagają adaptowalnych reakcji AI.

Badania Anthropic przyciągają uwagę zarówno deweloperów, etyków, jak i organów regulacyjnych. Jest to ważny krok w kierunku priorytetowego traktowania bezpieczeństwa i kontroli w szybko rozwijającej się dziedzinie sztucznej inteligencji, rzucający światło na nową granicę odpowiedzialności i etyki technologicznej.

Wreszcie, wprowadzenie wektorów persony podkreśla również stale ewoluującą relację między ludźmi a sztuczną inteligencją. W miarę jak zbliżamy się do zaawansowanych systemów sztucznej inteligencji, utrzymanie kontroli nad tymi systemami staje się istotnym tematem dyskusji. Jest to zgodne z misją Anthropic, aby zapewnić, że systemy AI są zrozumiałe, bezpieczne i zgodne z ludzkimi wartościami. Jeśli się powiedzie, może to uczynić wektory persony kwintesencją narzędzia w przyszłym rozwoju i wdrażaniu modeli uczenia się języka.

Aby uzyskać więcej informacji na temat badania Anthropic i niuansów wektorów persony, odwiedź oryginalny artykuł tutaj.